¿Qué es el chipset de una placa base y por qué es tan importante?

Uno de los elementos que mejor debemos conocer de nuestra placa base es su chipset, ya que este es fundamental para conocer la compatibilidad de nuestro procesador con ella. ¿Pero sabemos todas las funciones que realiza este chip en nuestra placa base? El chipset es fundamental en nuestro sistema y os vamos a explicar por qué.

¿Qué hace el chipset de nuestras placas base?

El chipset hace la función de hub de comunicaciones y de centro de control de tráfico en la placa base. Al tener estas dos funcionalidades, se convierte en el elemento más importante ya que facilita la comunicación entre casi todos los componentes de nuestro ordenador.

Según el chipset que tengamos, nuestro sistema será compatible con diferentes procesadores, modelos de discos duros, SSD y tarjetas gráficas. También determina que y cuántos periféricos soporta el sistema.

El chipset ha sufrido un importante cambio en los últimos años

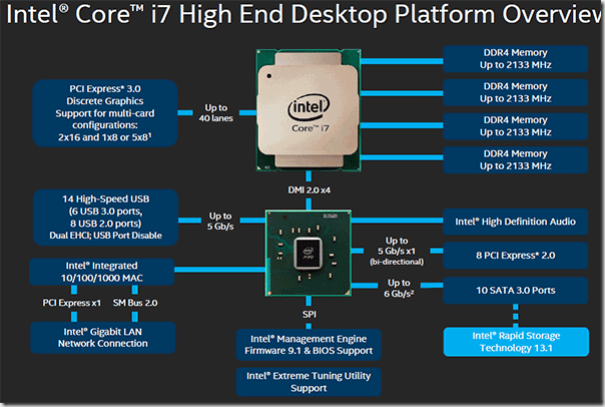

Antes, el chipset estaba formado por dos chips, el North Bridge, puente norte, y el South Bridge, el puente sur.

Al puente norte llegaban las comunicaciones más importantes: la memoria RAM, los puertos PCIe x16 y las salidas de vídeo del sistema. El NB estaba conectado directamente al procesador, mientras que el SB se comunicaba con el procesador a través del NB. El puente norte tenía un bus bastante más grande que el puente sur, ya que los datos más importantes se gestionaban desde él. Al puente sur llegaban las comunicaciones de los controladores de USB, discos duros, SSD, audio, Ethernet…

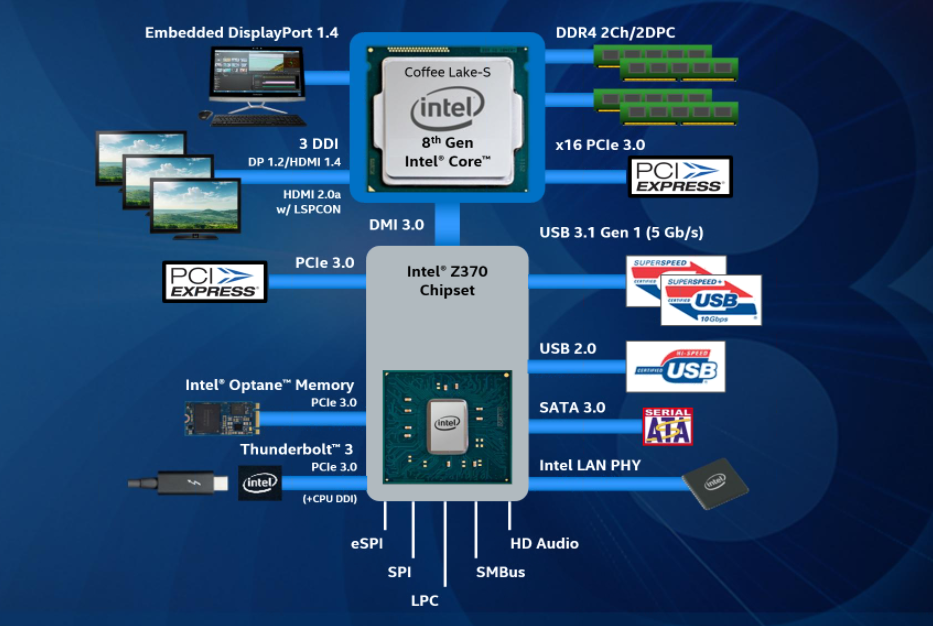

Actualmente se ha redibujado el mapa del chipset, consiguiendo que el puente norte desaparezca y las conexiones que ante se hacían desde él ahora se hagan directamente desde el procesador.

Esto consigue que los datos se transporten mucho más rápido y nuestro procesador maximice el rendimiento. Por lo que el chipset está formado por lo que antes se conocía como puente sur y ahora como PCH (Platform Controller Hub).

El bus que conecta el PCH con el procesador ha de operar muy rápido, sin embargo, no llega a tener la frecuencia a la que operan los procesadores, de hecho, ningún elemento de nuestro ordenador es tan rápido, por lo que reducir al máximo la latencia ha sido uno de los objetivos principales de las empresas.

Para conseguir mejorar el rendimiento y conseguir una comunicación más directa de la CPU con los componentes, fue necesario eliminar un bus: el que conectaba el puente norte con el procesador ya que sus bajas frecuencias hacían cuello de botella y ralentizaban el procesamiento de datos hacia la CPU.

Cada vez más buses y puertos usan este dispositivo integrado en placa.

Un chipset actual engloba un gran cantidad de buses de la placa base, que han pasado de tener sus propios controladores independientes a englobarse dentro del propio PCH. Por ejemplo, ahora vemos los controladores SATA 6 Gb/s, las tarjetas Ethernet por PHY, buses de audio que no sean dedicados con chips profesionales, y ciertas líneas PCIe que no puede albergar el propio procesador por pura arquitectura.

Además, controla las salidas de vídeo como HDMI, DisplayPort, DVI e incluso VGA mediante las líneas PCIe que tiene delimitadas. No podemos olvidar que también ofrece control sobre distintos sistemas de I/O, como pueden ser tarjetas de red inalámbricas, sistemas Bluetooth, puertos de infrarojos.

¿Qué es un microprocesador?

Se llama microprocesador o simplemente procesador al circuito integrado central de un sistema informático, en donde se llevan a cabo las operaciones lógicas y aritméticas (cálculos) para permitir la ejecución de los programas, desde el Sistema Operativo hasta el Software de aplicación.

Un microprocesador puede operar con una o más CPU (Unidades Centrales de Procesamiento), constituidas cada una por registros, una unidad de control, una unidad aritmético-lógica y una unidad de cálculo en coma flotante (o coprocesador matemático).

Asimismo, se haya generalmente conectado mediante un zócalo a la placa base o tarjeta madre, junto con un sistema disipador de calor que conforman ciertos materiales de disipación témica y un fan cooler (ventilador inerno).

Mientras que un mismo microprocesador puede contar con uno o más núcleos físicos o lógicos, en los que se lleva a cabo toda la labor de cálculo, un mismo sistema informático puede disponer de varios procesadores trabajando en paralelo.

El rendimiento de dichos procesadores no es nada fácil de medir, pero se suele usar la frecuencia de reloj (medida en herzios) para distinguir entre la potencia de unos y de otros.

Historia del microprocesador

Los microprocesadores surgieron como producto de la evolución tecnológica de dos ramas específicas: la computación y los semiconductores. Ambos tuvieron sus inicios a mediados del siglo XX, en el contexto de la Segunda Guerra Mundial, con la invención del transistor, con el que se reemplazó a los tubos al vacío.

A partir de entonces, se usó el silicio para generar circuitos electrónicos simples, dando pie posteriormente (el inicio de la década de 1960) a la creación de los primeros circuitos digitales: Lógica Transistor-Resistor (RTL), Lógica Transistor Diodo (DTL), Lógica Transistor-Transistor (TTL) y Lógica Complementada Emisor (ECL).

El siguiente paso hacia los microprocesadores sería la invención de los circuitos integrados (SSI y MSI), permitiendo así el inicio de la agregación y miniaturización de componentes. Las primeras calculadoras en emplear esta tecnología requerían sin embargo entre 75 y 100 circuitos integrados, lo cual era impráctico. Y así, el siguiente paso en la reducción de la arquitectura computacional fue el desarrollo de los primeros microprocesadores.

El primer procesador fue el Intel 4004 fabricado en 1971. Contenía 2300 transistores y con sus apenas 4 bits de capacidad podía realizar 60.000 operaciones lógicas por segundo, en una frecuencia de reloj de 700 Hz. A partir de entonces, la carrera tecnológica invirtió en el desarrollo de mejores y más potentes microchips: de 8 bits, 16 bits, 32 bits y 64 bits, alcanzando en la actualidad frecuencias superiores a los 3 GHz.

Características del microprocesador

Los microprocesadores asemejan una pequeña computadora digital en miniatura, por lo que presenta su propia arquitectura y realiza operaciones bajo un programa de control. Dicha arquitectura se compone de:

· Encapsulado. Una cubierta cerámica que recubre el silicio y lo protege de los elementos (como el oxígeno del aire).

· Caché. Un tipo de memoria ultrarrápida disponible para el procesador, de modo que no emplee memoria RAM sino cuando sea necesario, ya que en los varios niveles de la memoria caché se guardan datos en uso para su recuperación inmediata.

· Coprocesador matemático. Llamada unidad de coma flotante, es la porción del procesador que se encarga de las operaciones lógicas y formales.

· Registros. Una memoria breve de trabajo en el procesador, diseñada para llevar el control de su propio funcionamiento y condiciones.

· Puertos. Los conductos que permiten al procesador comunicar la información con el resto de los componentes del sistema.

¿Para qué sirve un microprocesador?

Los microprocesadores son el “cerebro” del computador: su centro lógico de operaciones aritméticas y lógicas, adonde van a ejecutarse todos los programas del sistema, tanto los propios del Sistema Operativo, como las aplicaciones ejecutadas por el usuario. Allí también se dan las lógicas binarias del sistema y los accesos a memoria. Es decir: el procesador es el motor informativo del computador.

Función del microprocesador

Un microprocesador opera en base a una serie de instrucciones elementales que son preprogramadas y almacenadas bajo la forma de código binario. Estas instrucciones van a organizarse a la memoria principal, y se dan de acuerdo a varias fases, que son:

Prefetch. O prelectura de la instrucción desde la memoria principal del sistema.

Fetch. Envío de la instrucción específica al decodificador.

Decodificación. Traducción de la instrucción en una serie de operaciones a realizar, y lectura de los operandos necesarios para hacerlo.

Ejecución. Realización de la instrucción por los componentes del sistema.

Escritura. Grabado de los resultados de vuelta en la memoria principal, o en los registros.

Estas fases se llevan a cabo en varios ciclos del CPU, y su duración depende de la frecuencia a la que trabaje el microprocesador.

¿Qué es la memoria RAM?

En informática, la memoria RAM (acrónimo de Random Access Memory, o Memoria de Acceso Aleatorio) es un tipo de memoria operativa de los computadores y sistemas informáticos, adonde va a ejecutarse la mayor parte del software: el propio sistema operativo, el software de aplicación y otros programas semejantes.

Su nombre proviene del hecho de que puede grabarse o recuperarse información de ella sin necesidad de un orden secuencial (como sí ocurre en la memoria ROM o Read-Only Memory, Memoria de Sólo Lectura), sino que puede accederse al RAM de la manera más rápida posible, con un tiempo de espera igual para cualquier posición de memoria.

La memoria RAM además es una forma de memoria temporal, que al apagar o reiniciar el sistema vuelve a estar en blanco. Esto considerando que al inicio del sistema los módulos básicos de funcionamiento (como el POST o el BIOS), inscritos a menudo en ROM, hacen un chequeo de la memoria RAM para asegurarse de que esté operativa y se pueda volcar en ella el software necesario para iniciar el sistema.

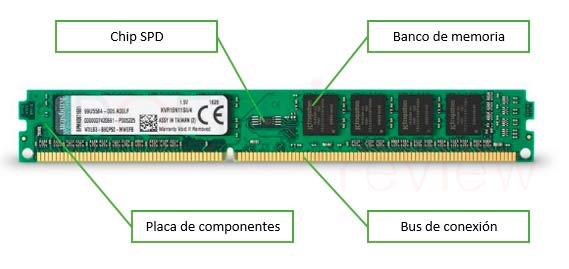

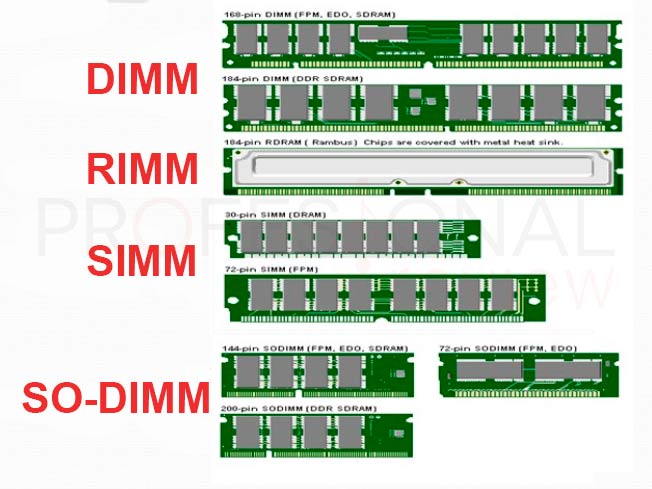

Este tipo de memoria no siempre se encuentra soldada a la placa madre (en las consolas de videojuegos, por ejemplo, sí lo está), sino que descansa en tarjetas de circuitos impresos retirables y sustituibles en la misma, conocidos como Módulos de RAM. Cada módulo posee un número de chips de memoria y una capacidad específica, medida actualmente en megabytes (1024 kilobytes) o gigabytes (1024 megabytes).

Hoy en día existen dos tipos de memoria RAM contrapuestos:

SRAM. Acrónimo de Static Random Access Memory (o sea: Memoria Estática de Acceso Aleatorio), designa un tipo de memoria que se sustenta en semiconductores y capaz de mantener los datos sin necesidad de circuitos de refrescamiento, siempre y cuando se mantenga alimentada. De este tipo son las memorias NVRAM (Non-volatile Random Access Memory, o RAM no volátil) y MRAM (Magnetoresistive Random Access Memory, o RAM magnética).

DRAM. Acrónimo de Dynamic Random Access Memory (o sea: Memoria Dinámica de Acceso Aleatorio), basa su tecnología en condensadores, que al perder carga progresivamente, requieren de un circuido de refresco que revisa su carga y la repone. Fue inventada a finales de 1960 y es el tipo más empleado actualmente, pues permite crear módulos de enorme densidad de posiciones y alta velocidad de recuperación. De este tipo son las memorias DRAM Asincrónica y SDRAM (Synchronous Dynamic Random Access Memory, o DRAM sincrónica).

¿Para qué sirve la memoria RAM?

Como se dijo antes, la RAM es la memoria operativa del sistema informático. Es el lugar adonde van a ejecutarse y a permanecer activos los diversos programas, desde el propio sistema operativo hasta las aplicaciones que utilicemos.

Por eso puede ocurrir que al mantener demasiadas aplicaciones activas simultáneamente, la capacidad de RAM del sistema se agote y ello repercuta en la calidad y la capacidad de cómputo.

La memoria RAM se conecta eléctricamente a un dispositivo concentrador de memoria, que gestiona las señales entrantes y salientes de la misma, por lo general consistentes en tres tipos de instrucción: direccionamiento, datos y señales de control.

Memoria RAM y memoria ROM

Las diferencias entre la memoria RAM y la ROM tienen que ver con que:

- La memoria RAM está siempre abierta a intervención y recuperación de la información, en cualquier momento, mientras que lo almacenado en la ROM puede ser únicamente recuperado y no intervenido.

- La memoria RAM permite el acceso indiscriminado a la información, desde cualquier posición o momento; mientras que la ROM requiere de un acceso secuencial a la misma.

- La memoria RAM es mucho más veloz que la ROM, por lo que a menudo los datos contenidos en esta última se envían y son ejecutados en la primera.

- La memoria RAM es retirable, aumentable, reemplazable, mientras que los módulos de ROM suelen venir instalados o soldados a la placa base por el fabricante mismo del computador y no pueden ser manipulados por el usuario.

¿Qué es un disco duro?

En pocas palabras, un disco duro para ordenador es un tipo de tecnología que almacena el sistema operativo, las aplicaciones y los archivos de datos que su ordenador utiliza para funcionar normalmente. Los demás componentes en su ordenador trabajan juntos para mostrarle las aplicaciones y archivos cuando usted lo desea.

Tipos de discos duros ¿Cuáles son todos los que existen?

Si bien es cierto, un disco duro hace referencia a aquel dispositivo del sistema de memoria de un ordenador que, por defecto, se emplea para guardar todos los programas, aplicaciones y archivos del usuario. Ya que, es el único elemento con la capacidad de guardar datos en todo momento (hasta cuando no está alimentado por la corriente eléctrica).

Es por ello que, la principal característica de un disco duro radica en su disposición de almacenaje, pues mientras mayor sea esta, más programas, documentos, fotografías, películas y canciones puede contener un PC. Además, su velocidad también es esencial porque influye en el tiempo de arranque de la máquina y los softwares.

Ahora bien, como existen una variedad de discos duros que deben diferenciarse, es importante puntualizar y detallar cuales son cada uno de ellos a fin de conocer sus particularidades más interesantes. Razón por la que, aquí te ofrecemos un listado con las clases de discos duros que se encuentran en el mercado.

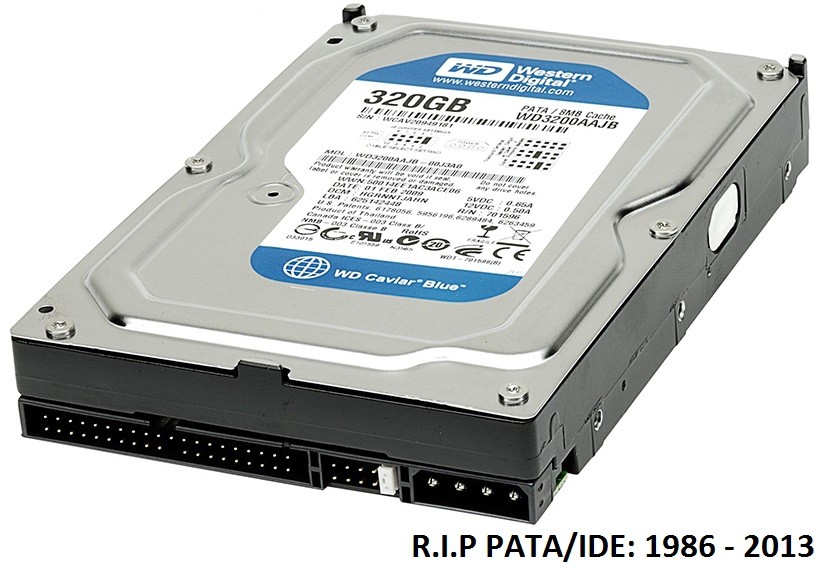

Discos duros HDD

También son conocidos como “discos duros mecánicos” o “discos duros magnéticos” y, básicamente, son los más tradicionales del mercado porque tienen la capacidad de grabar la información de forma magnética a través de uno o varios platos o discos. De modo que, tienen un funcionamiento similar a un pequeño tocadiscos.

Así, los discos duros HDD se caracterizan por estar formados, principalmente, por piezas mecánicas en las que varios platos rígidos giran a gran velocidad en torno a un eje ubicado en el interior de una caja. De esa manera, un cabezal de en cada disco se ocupará de leer o grabar datos sobre cada una de sus caras. También es preciso resaltar que, son los más económicos y duraderos, por lo que se han usado durante décadas.

Discos duros SSD

Estos también son llamados “discos de estado sólido” y son aquellos que, en lugar de utilizar discos giratorios para cumplir con su objetivo fundamental de guardar datos, utilizan matrices de transistores. De tal forma que, cada uno de dichos transistores se ocupa de almacenar una unidad de información y como no hay partes móviles, el acceso es mucho más rápido.

Por ende, los dispositivos SSD no tienen nada que ver con los clásicos discos HDD y únicamente se incluyen dentro de la misma clasificación, porque se dedican a cumplir oficios similares. Por otro lado, gracias a que presentan la ventaja de consumir menos energía, son más resistentes a los golpes, exhiben mayor rapidez y no producen un ruido sustancial, han sido los discos duros más exitosos durante los últimos años.

No obstante, son discos duros más costosos y tienen menor capacidad de almacenamiento que los HDD. Por lo que, muchas personas han optado por emplear un SSD para ejecutar el sistema operativo de un equipo y, además, reservan un HDD para el almacenamiento de datos exclusivamente. Por otro lado, los discos duros también se clasifican dependiendo de sus conectores o bien, de su interfaz.

TIPOS DE DISCOS DUROSY SU INTERFAZ

Discos duros SATA

Son aquellos discos duros que se emplean en equipos domésticos, mayormente, es decir, en equipos de sobremesa o computadoras portátiles. Los cuales, también son llamados “discos duros Serial ATA” y se caracterizan por utilizar un conector serie encargado de efectuar la transmisión de datos. En términos generales, se distinguen por funcionar con una velocidad cercana a los 150 megabytes por segundo, principalmente.

En ese sentido, se trata de discos duros con gran popularidad en el mundo de la informática y, por ende, se refiere a uno de los más usados durante los últimos años. Resaltando que, proporciona ventajas en torno a su velocidad de trasmisión de datos y a su precio.

También cabe acotar que, existen tres clases de discos duros SATA y son:

SATA – 1: Este logra una velocidad de hasta 150 Mb de transferencia de datos.

SATA – 2: Puede alcanzar una velocidad de transferencia de hasta 300 Mb, es decir, el doble que el SATA 1.

SATA – 3: En vista de que logra una velocidad de transferencia de hasta 600 Mb, se cataloga por exhibir un mayor rendimiento y es el más solicitado en relación a los demás SATA. Además, su tamaño es pequeño y, aun así, garantiza gran capacidad.

Discos duros SAS o SCSI

En general, consiste en conectores de discos duros que se usan a nivel profesional y, por ello, son ideales para entornos de alto rendimiento. Entre sus principales particularidades, encontramos que son capaces de reemplazar a otros discos duros similares sin tener que apagar el ordenador. Por eso, permite que el servicio siga operando con normalidad y sin interrupción alguna.

Por su parte, tanto los discos duros SAS como también los SCSI suelen hallarse en el interior de blades o racks y se encuentran instalados en RAID. Ahora bien, en el caso de los SAS, se destacan por ser los más usados en servidores y pueden cubrir hasta 24 ordenadores porque es posible conectarlos a 6 o 7 metros de distancia. Por otro lado, los SCSI exigen un controlador para poder operar y cuentan con una interfaz pequeña.

Aparte de todos estos tipos de discos duros, también se conocen aquellos que son seccionados dependiendo de su localización. Por lo cual, son los discos internos y externos, básicamente.

Discos duros internos

Tal y como su nombre lo indica, son aquellos discos que se ubican dentro de la caja del ordenador o el gabinete del sistema. Entre sus particularidades de mayor importancia, definimos que utiliza un sistema de grabación magnética con el objetivo de almacenar datos digitales que se encuentran dentro de cualquier ordenador portátil o de sobremesa.

Sumado a ello, un disco duro interno se enfoca en emplear la energía proporcionada por el mismo sistema. Ahora bien, tomando en cuenta sus beneficios, destacamos que ofrece mayor capacidad de almacenamiento, cuenta con una mayor rapidez y precisión en la lectura de los datos y tienen una durabilidad notable.

Discos duros externos

En este caso, se trata de un disco duro que se conecta al ordenador por medio de una conexión USB o SATA externa. De este modo, son ideales para guardar datos o información que no se deban utilizar todos los días o de modo constante, debido a que son dispositivos más lentos.

Entre sus mayores ventajas, encontramos que permiten realizar un óptimo respaldo del sistema completo y ofrece la posibilidad de almacenar archivos muy grandes, sin que esto influya en el rendimiento del ordenador. Por tanto, exhiben menos desorden en el disco duro y asegura una mayor portabilidad.

Considerando que, así son empleados para añadirles una capacidad adicional a un equipo y también son habitualmente usados para reproductores de contenidos audiovisuales en TV.

No hay comentarios:

Publicar un comentario